這是一個真實的故事。前幾天,我和一群小夥伴在新加坡參加了一場神秘的黑客大會,具體是什麽大會,以後再說。我先說說你們感興趣的“尋找紅燈區事件”。

我們本來純潔地打算尋找吃榴梿的聖地,不料女導遊神秘兮兮地介紹,新加坡有個地區叫芽籠,是個開展合法羞羞服務的區域,就在你們吃榴梿的地方附近哦。

蛤?貴坡還有這麽不符合我們社會主義核心價值觀的地方?

車上的小夥伴頓時來了興致,強烈要求司機載著我們在牙龍區域晃蕩一圈。而且,一位男同學提出了一個相當正經的問題:聽說提供這些服務的場所就隱藏在大街小巷裏,我們怎麽區別什麽樣的場所是紅燈區?迷路怎麽辦?

女導遊羞澀地朝著一個方向指過去:你們看,新加坡的這些街巷分成了單雙號,在這個區域,單號街道都是正經吃喝的地方,一般紅燈區隱藏在雙號街道裏哦。

【 圖片來源:新加坡眼所有者:新加坡眼 】

爲了再一次教我們辨別什麽是提供特殊服務的小店,導遊指出,一般在這些場所外面,會挂上兩個紅燈籠,這些燈籠會在夜晚點亮。

可是,這輛大巴轉了許久,我們還是沒有看到紅燈籠,不禁失望至極,導遊安慰我們:對了,有些場所不挂燈籠,但有 bling bling 的霓虹燈,你們如果在這個區域的雙號街巷看到閃爍的五顔六色,那就八九不離十了!

我之所以想起尋找紅燈區事件,是因爲1月16日,我參加了阿裏安全部的一次年度媒體溝通會,AI 鑒黃被作爲一個典型的安全 AI 應用案例推出。我才發現,相較于肉身尋找紅燈區,AI 早就在鑒定黃賭毒上一路狂奔了。

但是,厲害如 AI 唐馬儒,竟然也面臨著安全風險。

本文作者:雷鋒網網絡安全專欄作者,李勤,微信:qinqin0511

攻擊者 VS AI老司機

我們來看看,發生了什麽。

阿裏目前有三大戰略領域:傳統電商、數字化娛樂和新零售,這三個領域都涉及到網絡安全,比如,原創內容保護、內容治理和網絡黑灰産對抗。

以內容治理爲例,由于淘寶體量巨大以及內容生態越來越繁榮,淘寶的短視頻每天的觀看量差不多能達到 20 億次,這就衍生了一個問題:如何讓內容合法合規?

阿裏安全部圖靈實驗室高級算法專家威視(花名)告訴我,在過去一年網信辦接到的各種違規信息舉報中,超過 70% 的舉報涉及色情低俗,這意味著,色情低俗風險確實是各種內容面臨的合規風險中占比最大的一種,所以,在巨大的信息中,運用 AI 尋找黃色內容,規避內容風險成了一個強需求。

現在出現了一類不正經的算法工程師,他們被稱爲“調包俠”,雖然他們可能並不理解 AI 技術底層如何實現,但特別擅長調包——調用別人的開源代碼,將一些非法信息灌進去,訓練出一個特殊模型。這導致了另一個問題——安全研究員辛辛苦苦訓練出的 AI 唐馬儒竟然可能叛變,就像被人塞了小紅包,對黃色內容睜一眼閉一眼。

【 圖片來源:pconline所有者:pconline 】

更讓人擔憂的是,還有更多安全對抗在發生。

第一回合:沒用上 AI 技術,違規信息對抗在不同媒體間轉移。

以商品信息爲例,一開始,色情低俗信息,直接寫在商品標題裏面,比如:“看爽片XXX”,立馬能找到不可描述的東東。

安全技術專家像打地鼠一樣,敲掉了標題裏的色情低俗。現在一搜“看爽片”“爽片”,出來的分別是這樣的商品:

【 雷鋒網注:僅爲搜索結果示例】

攻擊者馬上把違規信息轉移到了商品的主圖、副圖中。由于色情圖片具有較強的視覺可分性,圖片的鑒黃比較容易開展,攻擊者發現自己被攔住之後,開始做拼接圖,把違規信息拼在一個正常背景中,或者通過翻拍逃避檢測。

甚至,當他們發現,算法對彩色圖片的識別效果好,攻擊者就用黑白圖片,後來,整張圖片容易被識別,就變成局部暴露,比如,衣服裹得嚴嚴實實的,只漏出關鍵的一點點。

或者,用美圖工具把常規照片轉換成鉛筆畫、蠟筆風格,甚至素描,當安全技術專家把這些問題解決了,攻擊者又想了一個新辦法——在圖片裏寫字,開始時,違規文字是正常的印刷體,被識別後,壞人開始用斜體、花體字;又被識別出來後,攻擊者幹脆用手寫,還故意寫得很潦草,不斷考驗識別算法和人類的想像力。

當圖片的鑒黃做得差不多時,違規信息轉戰到了視頻、直播裏,用音頻來做。當違規音頻也被幹掉時,攻擊者更狡猾了,他們把信息拆解開,在圖片、文本、語音中分散放置,變成一個典型的多模態問題,這時需要綜合各方信息進行判斷。

第二回合:高端對抗,壞人掌握了AI 技術。

這種攻擊者不僅是調包俠,還懂得了AI技術底層的一些特點。他能進行什麽騷操作?

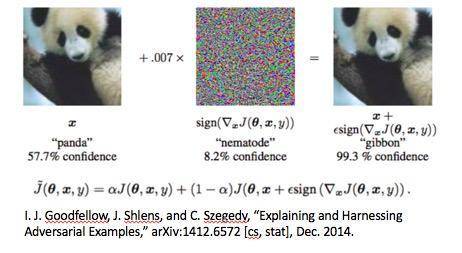

曾有一篇經典論文指出,本來模型識別一張圖片,正常的輸出結果是一只大熊貓,但是壞人經過一些簡單運算,比如像素級別的操作,得到一張新圖片,人眼看上去還是一只大熊貓,但是欺騙了識別模型,被模型判斷爲一只長臂猿。

壞人是如何做到的?

第一種情況,攻擊者知道鑒黃的算法、模型和網絡結構。

威視將這種情況稱爲“白盒攻擊”,這種攻擊並不複雜和困難,只要花的時間足夠長,耐心嘗試密碼,攻擊者總可以打開盒子。

第二種情況,算法使用的模型是不公開的。

在這種黑盒攻擊下,攻擊者不斷用不同圖片調用公開的算法接口,分析返回的結果,不斷嘗試驗證哪些方法可以讓AI唐馬儒輸出的結果含糊不清,直到嘗試出來某一種修改能夠攻破威視等人建立的模型。

威視說,黑盒攻擊比白盒攻擊成本高很多,這就是閉源模型好處。事實上,沒有什麽模型是不可被攻破的,只是攻擊成本的高低。安全技術專家要做的,就是不斷提高攻擊門檻。

除了面對攻擊者的威脅,AI 鑒定內容風險時還面臨天然阻礙:

一是大海撈針,違規信息可能占比不到千分之一,違規樣本和正常樣本數量呈現出極度的不均衡的態勢。

一是新增風險,安全場景面臨的新風險往往“臨時爆發”,誰能想到,直播主進行吃播時也可能涉黃。。。emmm,比如吃香蕉、喝酸奶等。

新風險下的新方法

對AI 唐馬儒而言,深度學習算法強依賴高質量的樣本,樣本的質量越高,數量越多,鑒定效果就越好。

威視介紹,爲此,他們提出了“小樣本學習(few-shot learning)”這樣的技術。這個方法主要解決兩個問題:第一,訓練中出現從來沒有見過的新類別,每個類別又只有很少的樣本;第二,訓練新樣本後,不能遺忘以前的知識,不能改變已有的模型。

針對上述問題,很多人想到用finetune(微調)的方式解決,也就是在已有模型基礎上,用新類別的樣本做微調訓練。但是,已有的模型依賴很大的樣本量訓練,比如,需要1000萬個訓練樣本。這時用幾十個、一百個樣本訓練新類別,基本改變不了網絡。而且,這種訓練還會遺忘以前的知識。

威視告訴我:“發現這條走不通後,我們考察了很多新方法,比如,度量學習(metric learning),學習類和類之間的度量,把不同的類間的距離盡可能地拉大,縮小同類之間的距離,用模式識別的話,就是增大了類間的方差,減少了類內的方差。”

基于度量學習的思路,他們嘗試了很多方法,比如,孿生網絡 (Siamese Neural Networks)、匹配網絡 (matching networks)、原型網絡 (Prototypical Networks)等。

這些方法的核心思想是,把樣本看作一個點,再來度量不同樣本在空間中的分布,利用算法合適地調整分布,讓新的類別在原來的樣本空間裏找到合適的位置,區別原有的類別。

後來,他們還發現了基于圖網絡(graph neural network)的方法,這種放在在度量學習的基礎上展開,圖網絡把樣本不僅看成一個點,它認爲,樣本和樣本之間是有關系的,用點和點之間的邊來表達,有點有邊就構成一張圖。度量學習只學習了點的信息,圖網絡既學習了點的信息,也學習了邊的信息,這樣就構成了網絡的學習,實際效果優于度量學習。

還有一種“元學習meta learning”方法,利用以往的知識經驗指導新任務的學習。AI算法不是從0開始構建自己的知識體系,而是在已有的知識體系之上,快速學習新技能。

威視等人設計了一種新方法,元學習中融合了度量學習的方法,用構成每個類的標簽樣本的的原型來表征類,進而通過相似度分類(KNN Classification)進行識別。他們在多個數據集上做了驗證,結果表明,該方法比基線有不錯的提升。

這種新方法被應用在阿裏雲內容安全的産品中,阿裏安全部提供了一個已有模型及訓練方法,第一線的運營人員發現可定義的新風險時,他們用幾十個或者上百個樣本,在頁面上點鼠標,上傳並標注樣本,這個模型就可以進行一次學習。學習之後,模型對沒有學習過樣本提出結論,這時運營人員需要標注算法的結果,判斷哪個做對了,哪個做錯了。大概重複兩到三輪,模型基本可用了。

這種方法可以讓AI應對大部分新增的風險,而且降低了對樣本的依賴性,縮短了響應的時間 。以前,安全人員需要收集信息,打標,訓練模型進行測試,周期比較長的。現在,這些事情都交給了第一線的業務人員,他們可以自主進行幾輪叠代和部署,模型可能在幾個小時內就能上線,防範新增的風險。

安全 AI 的想像

AI 唐馬儒要想比真的唐馬儒更厲害,還需要發揮一些想像力。

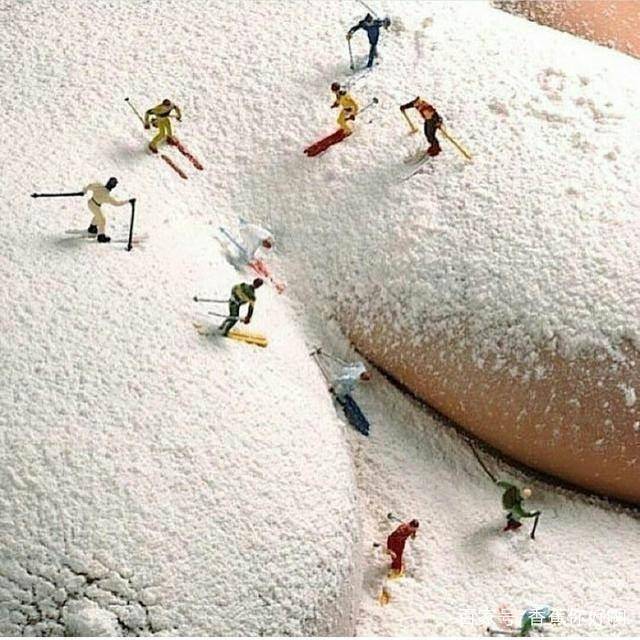

在阿裏安全圖靈實驗室的實踐中,安全人員發現,AI 模型擅長在一些“老司機心知肚明的情況下”處理視覺可分性的任務,比如出現某種明顯標志,或者出現了某種動作和場景,但在業務的審核標准裏,很多時候連人都需要“腦補”,AI 就面臨更艱巨的任務了,比如,在色情低俗的場景下,照片裏並沒有呈現完整的違規場景,AI表示無能爲力,但人卻可以想像畫面之外發生了什麽。

【 滑雪勝地,圖片來源:百家號所有者:Strange咖 】

即使 AI 唐馬儒成了業務相當熟練的老司機,他可能也會忙到吐血,因爲新風險實在太多了!

面對不同風險點,難道要每一種都做出來一個模型嗎?威視希望,設計多任務網絡,模型不僅可以判斷色情低俗風險,同時可以判斷廣告,還可以找人臉,多任務合並到一個網絡中。對于計算成本,現在有一種趨勢是,業界開始做專門的AI芯片,大幅度提升計算效率,降低成本。

當然,這些僅僅只是一類案例。說了這麽多,到底什麽是“安全AI”?爲什麽在大家都提AI、AI安全時,阿裏安全要“別出心裁”地來這麽一出,並告訴大家,阿裏安全要“ALL IN 安全AI”?

阿裏安全研究員陸全稱:“我們阿裏安全有這樣一個場景,把 AI 在安全場合進行打磨。其實我們通過 AI 應用在安全去保護AI,通過這樣一個不斷叠代的過程,把這兩個東西形成一個整體。這個整體叫做‘安全AI’,它可以自我進化。”

進化的結果是,他們想培養出一種“人”,“他”是天生就是很好的拳擊手,具備高靈活性,非常強壯,還要有高對抗性,最後反哺通用的AI,對整個AI領域提供幫助,促進人工智能的發展。

雖然結尾如此有雄心壯志 ,機智如你,可能想知道一個問題:你們到底有沒有找到紅燈區?

A.找什麽找,吃貓山王才是正經事。

B.晚上一波人在一個地方偶遇,啊呸,你們在想什麽?

C.人不如 AI 老司機,唐馬儒別哭,起來再戰。

【 圖片來源:haoqilu所有者:haoqilu 】

致謝:該文得到了阿裏安全圖靈實驗室高級算法專家華棠、覺奧以及阿裏安全資深技術專家鐵花的幫助。

本文作者:雷鋒網網絡安全專欄作者,李勤,微信:qinqin0511