選自Medium

作者:Elvis機器之心編譯

在整個2019年,NLP領域都沉澱了哪些東西?有沒有什麽是你錯過的?如果覺得自己梳理太費時,不妨看一下本文作者整理的結果。

2019 年對自然語言處理(NLP)來說是令人印象深刻的一年。本文將著重講述一些 2019 年我在機器學習和自然語言處理領域有所見聞的重要事件。我會把重點主要放在自然語言處理上,但也會涉及若幹人工智能領域的趣聞。主要內容包括研究論文、博客、工具和數據集、社區討論、教程資源等。

長文預警,建議先點收藏。

目錄

- 研究論文

- 機器學習/自然語言處理的創造力和社群

- 工具和數據集

- 博文文章

- 教程資源

- 人工智能倫理學

研究論文

2019 年,谷歌人工智能團隊帶來了

ALBERT

,它是用于情境化語言表征的自監督學習模型

BERT

的精簡版。主要的改進在于減少了冗余,更加有效地分配了模型的性能。此方法在 12 個自然語言處理任務上達到了當前最佳性能(SOTA)。

2018 年底,英偉達的研究者們發表了一份熱門論文 (A Style-Based Generator Architecture for Generative Adversarial Networks)(取名爲

StyleGAN

),提出了對抗生成網絡的另一種生成器架構,靈感來自于風格遷移問題。2019 年,這份工作有了更新 (

Analyzing and Improving the Image Quality of StyleGAN

),著重研究了諸如重新設計生成器正則化的過程等方面。

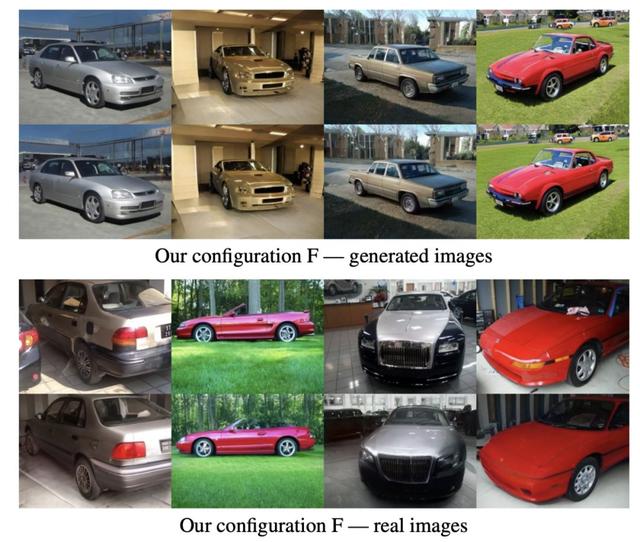

上面一行爲目標圖像,下面一行爲合成圖像。圖源:https://arxiv.org/abs/1912.04958

2019 年,我最喜歡的論文之一是 code2seq (https://code2seq.org/),這是一種從結構化表征的代碼中生成自然語言序列的方法。這樣的研究可以對自動代碼摘要和文檔化的應用起到助益。

你可曾想過,有沒有可能爲生物醫學文本挖掘訓練一個生物醫學的語言模型?答案就是 BioBERT (BioBERT: a pre-trained biomedical language representation model for biomedical text mining),這是一個可以從生物醫學文獻中提取重要信息的語境化模型。

在 BERT 發表後,Facebook 的研究者們發布了 RoBERTa (RoBERTa: A Robustly Optimized BERT Pretraining Approach),引入新的優化方法來改進 BERT,也在多項自然語言處理的基准測試中達到了當前最優效果。

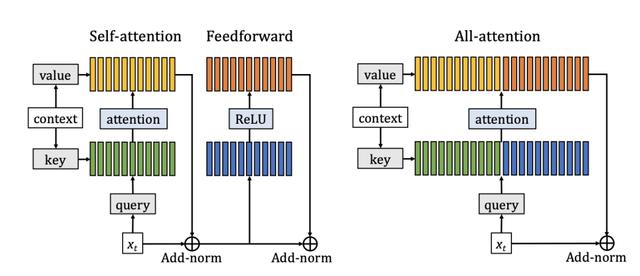

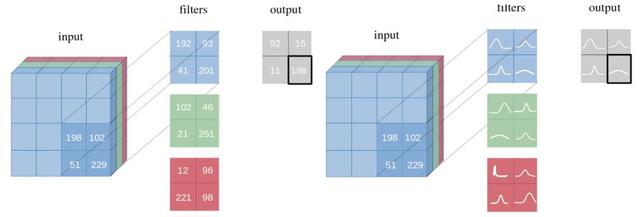

最近,Facebook 人工智能部門的研究者們還發表了一種基于全注意力層來改進 Transformer 語言模型效率的方法 (https://ai.facebook.com/blog/making-transformer-networks-simpler-and-more-efficient/)。這個研究組的其它工作 (https://ai.facebook.com/blog/-teaching-ai-to-plan-using-language-in-a-new-open-source-strategy-game/) 還包括了如何教人工智能系統通過制定計劃來使用自然語言。

全注意力層。圖來:https://arxiv.org/pdf/1907.01470.pdf

可解釋性仍然是機器學習和自然語言處理領域的重要議題。這篇論文 (Explainable Artificial Intelligence (XAI): Concepts, Taxonomies, Opportunities and Challenges toward Responsible AI) 對于可解釋性、分類法以及未來研究的機遇提供了一份全面的綜述。

Sebastian Ruder 的博士論文也值得一看,題爲:Neural Transfer Learning for Natural Language Processing。

新加坡國立大學等機構的研究者開發了一種方法 (Emotion Recognition in Conversations with Transfer Learning from Generative Conversation Modeling),能夠在對話的情境下實現情緒識別,這將爲情感化的對話生成鋪平道路。

另一項相關工作則是用一種叫做 DialogueGCN (DialogueGCN: A Graph Convolutional Neural Network for Emotion Recognition in Conversation) 的圖神經網絡方法,來探測對話中的情緒。作者還提供了代碼實現:https://github.com/SenticNet/conv-emotion/tree/master/DialogueGCN。

谷歌量子人工智能團隊在 Nature 發表了一篇論文,聲稱開發了一台

量子計算機

,速度比世界上最大的超級計算機更快。

之前提到過,可解釋性是神經網絡架構裏需要大幅改進的一個領域。這篇論文 (

Attention is not not Explanation

) 討論了在語言模型的情境下,注意力機制作爲可解釋性的一種可靠方法所具有的局限性。

神經邏輯機 (

Neural Logic Machines

) 是一種神經符號網絡架構,在歸納學習和邏輯推理上效果都不錯。這個模型尤爲擅長數組排序和尋找最短路徑之類的任務。

神經邏輯機架構。圖源:https://arxiv.org/pdf/1904.11694.pdf

這裏還有一篇論文 (

On Extractive and Abstractive Neural Document Summarization with Transformer Language Models

),把 Transformer 語言模型應用到了抽取式和摘要式 Neural document summarization。

研究者們開發出了一種方法,著重于利用比較來打造和訓練機器學習模型。這種方法 (https://blog.ml.cmu.edu/2019/03/29/building-machine-learning-models-via-comparisons/) 不需要大量的特征-標簽對,它將圖像與之前見過的圖像相比較,以判定這張圖像是否應該屬于某個標簽。

Nelson Liu 等發表的論文 (Linguistic Knowledge and Transferability of Contextual Representations) 討論了 BERT 和 ELMo 等預訓練的語境模型所捕捉到的語言學知識類型。

XLNet

是一種自然語言處理的預訓練方法,在 20 個任務上比 BERT 更勝一籌。我在這裏(https://medium.com/dair-ai/xlnet-outperforms-bert-on-several-nlp-tasks-9ec867bb563b) 寫過一篇關于這項重要研究的總結。

這份 DeepMind 的研究 (Learning and Evaluating General Linguistic Intelligence) 展示了一項涉及面廣泛的實證調查結果,其目的爲評估用于各種任務的語言理解模型。這項分析對于更好地理解語言模型捕獲的內容、提高模型效率尤爲重要。

VisualBERT (VisualBERT: A Simple and Performant Baseline for Vision and Language) 是一個小而強大的框架,用于爲圖像-語言類任務建模,相關任務包括 VQA 、Flickr30K 等。這個方法運用了堆疊的 Transformer 層和自注意力機制,來對齊一段文本和一塊圖像區域之中的元素。

這份研究 (To Tune or Not to Tune? Adapting Pretrained Representations to Diverse Tasks) 提供了一份比較自然語言處理遷移學習方法的詳盡分析,以及爲自然語言處理工作者們准備的指南。

Alex Wang 和 Kyunghyun 提出了 BERT 的一種實現方法 (BERT has a Mouth, and It Must Speak: BERT as a Markov Random Field Language Model),可以生成高質量且流暢的結果。你可以使用這份 Colab 筆記本來試試:https://colab.research.google.com/drive/1MxKZGtQ9SSBjTK5ArsZ5LKhkztzg52RV

Facebook 的研究者們發布了 XLM 的 PyTorch 版代碼 (https://github.com/facebookresearch/XLM),這是一個跨語言的預訓練模型。

這份研究 (https://www.cl.uni-heidelberg.de/statnlpgroup/blog/rl4nmt/) 對神經機器翻譯領域強化學習算法的應用做了綜合分析。

這篇在 JAIR 上發表的論文 (A Survey of Cross-lingual Word Embedding Models) 對跨語言詞嵌入模型的訓練、評估和使用做了全面綜述。

The Gradient 上發表了一篇極佳的文章 (https://thegradient.pub/the-promise-of-hierarchical-reinforcement-learning/),詳述了當前強化學習的局限性,並提供了利用分層強化學習的潛在發展方向。很快就有人發布了一系列優秀的教程 (https://github.com/araffin/rl-tutorial-jnrr19/blob/master/1_getting_started.ipynb),你可以通過這組教程來開始接觸強化學習。

這篇論文 (

Contextual Word Representations: A Contextual Introduction

) 是情境化詞表征的精簡版入門讀物。

機器學習/自然語言處理的創造力和社群

機器學習被用于解決真實世界的各種問題,同時它也被用在了一些有趣且有創造力的地方。機器學習的創造力和人工智能的任何其他研究領域同樣重要,因爲最終,我們希望造出能夠幫助我們塑造文化和社會的人工智能系統。

到了年末之際,Gary Marcus 和 Yoshua Bengio 在深度學習、符號人工智能和混合型人工智能系統的想法等議題上進行了

辯論

。

2019 斯坦福年度AI報告

于年底面世,報告中對于人工智能現狀全面的分析可以幫助我們更好地理解人工智能的整體進程。

常識推理仍舊是一個重要的研究領域,因爲我們想要建造的人工智能系統,不僅應該能基于數據做預測,還應該理解這些決定並對它們進行推理。這類技術可以用于對話式人工智能,其目的是使得智能代理能夠自然地和人們進行對話。看看 Nasrin Mostafazadeh 的這份采訪 (https://www.forbes.com/sites/ayurellahornmuller/2018/12/31/the-art-of-ai-storytelling-how-one-30-under-30-scientist-is-teaching-devices-to-make-assumptions/#12824a1e2a4f)。

他在采訪中討論了常識推理以及講故事、語言理解等應用。你也可以看看這篇關于如何在常識推理中運用語言模型的新論文 (Explain Yourself! Leveraging Language Models for Commonsense Reasoning)。

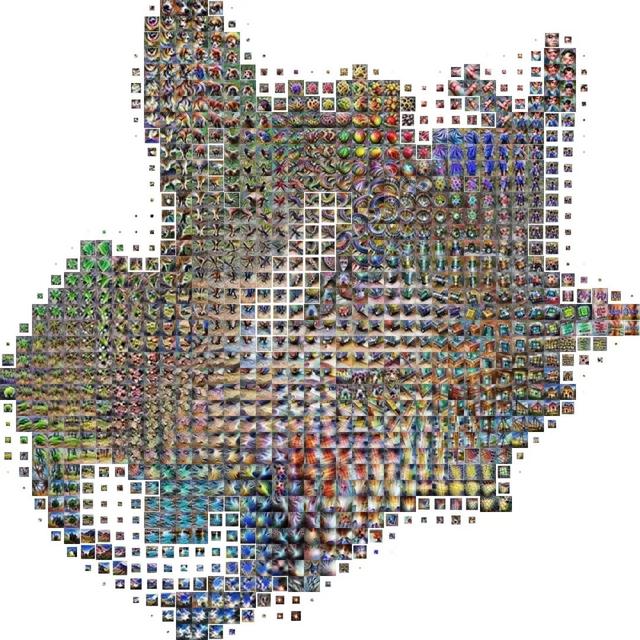

激活圖譜

是谷歌和 Open AI 的研究者們開發的一項技術,用于更好地理解和可視化神經網絡中神經元之間發生的交互。

InceptionV1 的圖像分類網絡的激活圖譜展示了很多完全實現的特征,如電子産品、建築物、食物、動物的耳朵、植物和多水的背景。圖來:博文 https://openai.com/blog/introducing-activation-atlases/

看一下 Geoffrey Hinton 和 Yann LeCun 出品的這份圖靈課程 (https://fcrc.acm.org/turing-lecture-at-fcrc-2019),今年他倆和 Yoshua Bengio 一起獲得了

圖靈獎

。

這篇論文 (Tackling Climate Change with Machine Learning) 討論了如何用機器學習應對氣候變化。

OpenAI 發表了一篇涉及面很廣的報告 (Release Strategies and theSocial Impacts of Language Models),討論了語言模型的社會影響力,包括合理使用以及潛在的技術濫用等主題。

情緒分析仍然被用于各種各樣的應用。The Mojifier (https://themojifier.com/) 是一個很酷的項目,它可以查看圖像並檢測其中的情緒,然後把臉替換成檢測到的情緒所對應的表情符號。

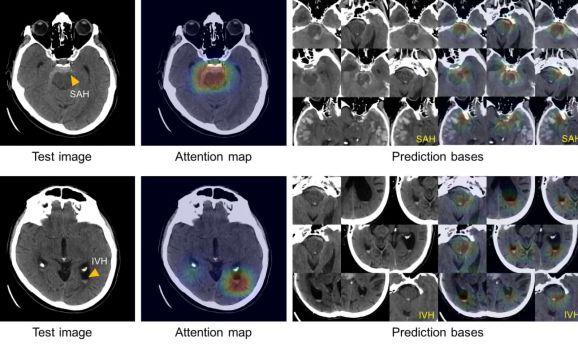

今年將人工智能技術應用于放射學的研究也十分熱門。這裏有篇不錯的文章 (Radiological images and machine learning: trends, perspectives, and prospects) 總結了這個研究領域的趨勢和展望。紐約大學的研究者們發布了一個基于 Pytorch 的深度神經網絡 (https://medium.com/@jasonphang/deep-neural-networks-improve-radiologists-performance-in-breast-cancer-screening-565eb2bd3c9f),能夠改進放射科醫生對乳腺癌的篩查。這裏還發布了一個重要的數據集,叫作 MIMIC-CXR (https://physionet.org/content/mimic-cxr/2.0.0/),其中包含了 X 光胸片和放射學文本報告的數據庫。

紐約時報寫了一篇報道 (https://www.nytimes.com/2019/01/02/obituaries/karen-sparck-jones-overlooked.html),記敘了 Karen Spark Jones 在自然語言處理和信息檢索領域做出的具有開創性的貢獻。

OpenAI Five (https://openai.com/blog/openai-five-defeats-dota-2-world-champions/) 成爲首個在電競遊戲上打敗世界冠軍的人工智能系統。

全球人工智能人才報告

對于世界範圍內的人工智能人才儲備,以及全球對人工智能人才的需求做了一份詳細的彙總。

DeepMind 團隊的播客 (https://deepmind.com/blog?filters=%7B%22category%22:%5B%22Podcasts%22%5D%7D)值得一看。這個節目的嘉賓們會討論人工智能當下最爲緊迫的話題。關于人工智能的潛力,Demis Hassbis 在經濟學人做了一個訪談 (https://worldin.economist.com/article/17385/edition2020demis-hassabis-predicts-ai-will-supercharge-science?utm_medium=pr&utm_source=inf-a&utm_campaign=worldin),談論了一些未來學的想法,比如把人工智能作爲人類大腦的延伸,或許能以此解決一些重要的科學問題。

2019 同樣見證了機器學習在健康領域的卓越發展。比如,麻省總醫院(波士頓綜合性醫院)的研究者們開發了一個可以識別腦出血的人工智能系統 (https://venturebeat.com/2019/01/04/massachusetts-generals-ai-can-spot-brain-hemorrhages-as-accurately-as-humans/),精度可以達到人類水平。

人工智能系統分析的腦部掃描

Janelle Shane 總結了一組「奇怪」的實驗 (https://aiweirdness.com/post/181621835642/10-things-artificial-intelligence-did-in-2018),展示了機器學習如何地被應用于各種有趣的實驗。有時候,這種實驗能幫助我們真正理解人工智能系統到底在幹什麽,以及沒有在幹什麽。有些實驗涉及把神經網絡用于生成假蛇,或者講笑話。

蛇的種類。圖源:https://aiweirdness.com/post/181621835642/10-things-artificial-intelligence-did-in-2018

學習如何使用基于 TensorFlow 的機器學習模型來尋找行星:https://www.blog.google/topics/machine-learning/hunting-planets-machine-learning/

OpenAI 討論了關于發布大規模無監督語言模型的擔心(包括潛在的惡意使用案例):https://openai.com/blog/better-language-models/#sample1

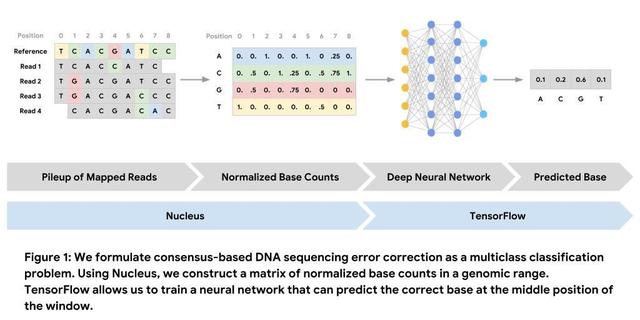

這個 Colab 筆記本有一份非常棒的入門教材:https://colab.research.google.com/github/google/nucleus/blob/master/nucleus/examples/dna_sequencing_error_correction.ipynb,幫助你學習如何把 Nucleus 和 TensorFlow 用于 DNA 序列糾錯。

這裏還有一篇優秀的博文 (https://blog.floydhub.com/exploring-dna-with-deep-learning/),講了如何把深度學習架構用于探索 DNA。

圖片來源:https://raw.githubusercontent.com/google/nucleus/master/nucleus/examples/images/consensus-approach-overview.jpg

Alexander Rush 是一位哈佛的自然語言處理研究者,他寫了一篇關于張量問題的

重要文章

,以及它們在當前的庫上是如何暴露出來的。他也談論了關于把命名索引用于張量的提議。

工具和數據集

這裏我主要記錄一些和軟件以及數據集有關的故事,這些軟件和數據集對自然語言處理和機器學習的研究和工程化起到了協助作用。

Hugging Face 發布了一個熱門的 Transformer 庫 (https://github.com/huggingface/transformers),基于 Pytorch,名爲 pytorch-transformers。它使得自然語言處理從業者和研究者能夠簡單地使用最先進的通用架構,諸如 BERT、GPT-2 和 XLM 等。

如果你對如何使用 pytorch-transformers 感興趣,你可以從很多地方開始著手。不過這篇 Roberto Silveira 的教程 (https://rsilveira79.github.io/fermenting_gradients/machine_learning/nlp/pytorch/pytorch-transformer-squad/) 非常詳盡,告訴你如何把這個庫用于機器閱讀理解,我特別喜歡。

TensorFlow 2.0 發布了,

有許多新的功能

。在這裏可以讀到最佳使用方法 (https://medium.com/tensorflow/effective-tensorflow-2-0-best-practices-and-whats-changed-a0ca48767aff)。François Chollet 還在這個 Colab 筆記本 (https://colab.research.google.com/drive/1UCJt8EYjlzCs1H1d1X0iDGYJsHKwu-NO) 中寫了一篇關于新功能的全面綜述。

PyTorch 1.3

發布了,多了一大堆的新功能,其中包括命名張量和其它前端的改進。

艾倫人工智能研究所發布了 Iconary (https://iconary.allenai.org/),這是一個可以和人類玩猜圖遊戲的人工智能系統。這項工作結合了圖像/語言學習系統和常識推理。他們還發表了一個新的常識推理基准 (Abductive Commonsense Reasoning),名爲 Abductive-NLI。

spaCy 發布了新的庫 (https://explosion.ai/blog/spacy-transformers),支持把 Tranformer 語言模型結合到他們自己的庫中,從而能夠在 spaCy 自然語言處理體系中提取特征並加以運用。這項工作基于 Hugging Face 開發的著名 Transformer 庫。Maximilien Roberti 還寫了一篇不錯的文章 (https://towardsdatascience.com/fastai-with-transformers-bert-roberta-xlnet-xlm-distilbert-4f41ee18ecb2),講述如何把 fast.ai 的代碼和 pytorch-transformers 結合起來。

Facebook 人工智能團隊發布了 PHYRE (https://phyre.ai/),這是一個物理推理的基准,目標是通過解決各種物理問題,測試人工智能系統物理推理的能力。

圖片來源:https://phyre.ai/

斯坦福的自然語言處理組發布了 StanfordNLP 0.2.0 (https://stanfordnlp.github.io/stanfordnlp/) 版本,這是一個用于自然語言分析的 Python 庫。你可以在 70 多種不同的語言上進行不同的語言分析,比如詞形還原和詞性標注。

GQA (https://cs.stanford.edu/people/dorarad/gqa/) 是一個視覺問答數據集,協助在視覺推理方面的研究。

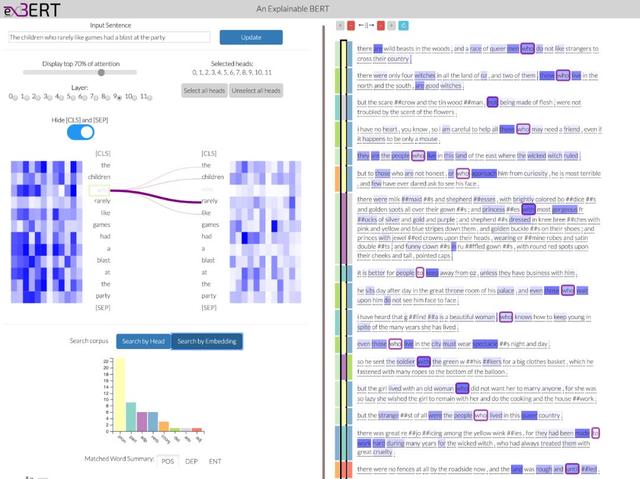

exBERT(exBERT: A Visual Analysis Tool to Explore Learned Representations in Transformers Models)是一個可視化交互工具,探索 Transformer 語言模型的嵌入向量和注意力。你可以在這裏 (http://exbert.net/) 嘗試 demo。

exBERT。圖源:http://exbert.net/

Distill 發表了一篇關于如何可視化循環神經網絡 (RNN) 的記憶過程的文章 (https://distill.pub/2019/memorization-in-rnns/)。

Mathpix

這個工具可以根據你提供的一張公式圖片輸出 latex 版本的公式。

圖片來源:https://mathpix.com/

Parl.ai (https://parl.ai/) 這個平台擁有許多知名數據集,涉及各項研究,包括對話和對話式人工智能。

Uber 的研究者們發布了 Ludwig (https://uber.github.io/ludwig/),這個開源的工具使得用戶們能夠簡單地訓練和測試深度學習的模型,只要寫幾行代碼即可。主要是爲了避免訓練和測試模型時的代碼量。

谷歌人工智能團隊發布了

「自然問題」數據集

,這是一個用于訓練和評測開放域上的問答系統的大規模語料庫。

博客文章

今年是 NLP 數據科學作家和愛好者數量激增的一年。這對我們的領域非常有益,我們也鼓勵更多的相互討論和學習。這裏我列出一些有趣且必看的博客文章:

Christian Perone 對最大似然估計(MLE)和最大後驗概率(MAP)進行了詳細介紹,它們是幫助我們理解如何估計模型參數的重要原理。文章鏈接:http://blog.christianperone.com/2019/01/mle/

Reiichiro Nakano 在博客中討論了基于對抗性魯棒分類器的神經風格遷移。文章鏈接:https://reiinakano.com/2019/06/21/robust-neural-style-transfer.html;Colab 筆記本鏈接:https://colab.research.google.com/github/reiinakano/adversarially-robust-neural-style-transfer/blob/master/Robust_Neural_Style_Transfer.ipynb

Saif M. Mohammad 撰寫了一系列文章討論了 ACL 的曆時分析。文章鏈接:https://medium.com/@nlpscholar/state-of-nlp-cbf768492f90

「三張圖分別表示從事 NLP 的平均學術年齡、中位數學術年齡以及作者在學術年齡發第一篇論文的百分比。」——圖片來源 https://medium.com/@nlpscholar/state-of-nlp-cbf768492f90

語言模型可以學習語法嗎?這篇文章通過使用結構探測證明使用上下文表示法和查找樹結構的方法是可行的。文章鏈接:https://nlp.stanford.edu/~johnhew/structural-probe.html

Andrej Karpathy 寫了一篇博客

總結了如何有效訓練神經網絡的方法並進行了實踐。

Google AI 研究人員和其他研究人員協作加強了對使用 BERT 模型的搜索理解。像 BERT 這樣的語境化模型足以理解搜索行爲背後的意圖。文章鏈接:https://www.blog.google/products/search/search-language-understanding-bert

Rectified Adam(RAdam)是基于 Adam 優化器的新優化技術,有助于改善 AI 架構。在尋找更好、更穩定的優化器上我們已經付出許多努力,但該文章稱要將重點放在優化的其他方面,這些方面對于提高收斂性同樣重要。文章鏈接:https://medium.com/@lessw/new-state-of-the-art-ai-optimizer-rectified-adam-radam-5d854730807b

隨著近來機器學習工具的大量開發,關于如何實現機器學習系統以解決實際問題的討論也越來越多。

Chip Huyen 寫了一篇有趣的文章討論了機器學習系統設計,強調了超參數調優和數據管道

。

NVIDIA 創造了最大語言模型的記錄

,訓練了數十億參數的模型。

Abigail See 撰寫了一篇不錯的博客,解釋如何在爲執行自然語言生成任務而開發的系統環境中進行良好的對話。文章鏈接:http://www.abigailsee.com/2019/08/13/what-makes-a-good-conversation.html

Google AI 發布了兩個自然語言對話數據集,旨在使用更複雜和自然的對話數據集來改善對話式應用程序,例如數字助理。文章鏈接:https://ai.googleblog.com/2019/09/announcing-two-new-natural-language.html

深度強化學習仍然是 AI 領域中討論最廣泛的話題之一,

它甚至引起了心理學和神經科學領域人員的興趣

。

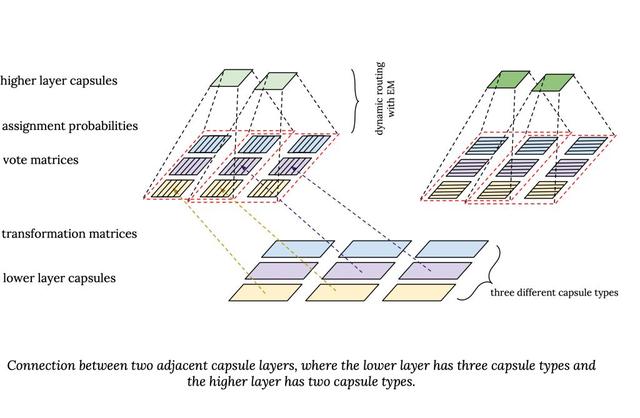

Samira Abner 撰寫了一篇博客,總結了 Transfoemer 和膠囊網絡及其連接背後的主要構造要素。文章鏈接:https://staff.fnwi.uva.nl/s.abnar/?p=108

Adam Kosiorek 在基于堆疊的膠囊自動編碼器(一種膠囊網絡的無監督版本)上寫了這篇文章,可以應用于目標檢測。文章鏈接:http://akosiorek.github.io/ml/2019/06/23/stacked_capsule_autoencoders.html

圖片來源:https://staff.fnwi.uva.nl/s.abnar/?p=108

研究人員在 Distill 上發表了一篇互動文章,旨在展示對高斯過程可視化的探索。文章鏈接:https://distill.pub/2019/visual-exploration-gaussian-processes/

通過 Distill,Augustus Odena 呼籲研究人員解決有關 GAN 的幾個重要的開放性問題。

圖卷積網絡(GCN)的 PyTorch 實現如下,可用于對垃圾郵件發送者和非垃圾郵件發送者進行分類。PyTorch 實現:https://github.com/zaidalyafeai/Notebooks/blob/master/Deep_GCN_Spam.ipynb

年初,VentureBeat 發布了由 Rumman Chowdury、Hilary Mason、Andrew Ng 和 Yan LeCun 等專家參與的

2019 預測列表

。可以看看他們的預測是否正確。

這篇文章解釋了如何優化 BERT 以執行多標簽文本分類:https://medium.com/huggingface/multi-label-text-classification-using-bert-the-mighty-transformer-69714fa3fb3d

由于 BERT 的流行,在過去的幾個月中,許多研究人員開發了一些方法來「壓縮」BERT,在原來版本的基礎上構建更快、更小且內存效率更高的版本。Mitchell A.Gordon 撰寫了一篇介紹壓縮類型與使用方法的綜述。文章鏈接:http://mitchgordon.me/machine/learning/2019/11/18/all-the-ways-to-compress-BERT.html

超級智能仍然是專家們爭論的話題。這是一個需要正確理解框架、政策以及仔細觀察的重要主題。我發現了一系列的有趣綜合文章,對于理解有關超級智能的問題和注意事項很有用。文章鏈接:https://www.fhi.ox.ac.uk/wp-content/uploads/Reframing_Superintelligence_FHI-TR-2019-1.1-1.pdf

Eric Jang 寫了一篇博客介紹了元學習的概念,旨在建立和訓練機器學習模型,這種模型不僅可以預測,而且可以學習。文章鏈接:https://blog.evjang.com/2019/02/maml-jax.html

Sebastian Ruder 總結了 AAAI 2019 的會議重點:https://ruder.io/aaai-2019-highlights/

圖神經網絡今年受到了廣泛的討論。David Mack 撰寫了一篇不錯的可視化文章,介紹了他們如何使用此技術並執行最短路徑計算。文章鏈接:https://medium.com/octavian-ai/finding-shortest-paths-with-graph-networks-807c5bbfc9c8

貝葉斯方法仍然是一個有趣的話題,尤其是如何將它們應用于神經網絡,以避免過擬合等常見問題。下面是 Kumar Shridhar 關于該話題建議的閱讀清單。文章鏈接:https://medium.com/neuralspace/bayesian-neural-network-series-post-1-need-for-bayesian-networks-e209e66b70b2

「以點估計爲權重的網絡與以概率分布爲權重的網絡」。圖片來源:https://arxiv.org/pdf/1806.05978.pdf

教程資源

在這一章,我將列出一系列教程資源。

CMU 發布了「NLP 神經網絡」

課程材料和教學大綱

。

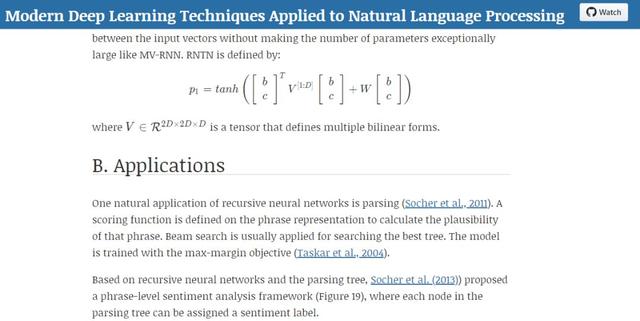

Elvis Saravia 和 Soujanya Poria 發布了一個名爲

NLP-Overview

的項目,旨在幫助學生和從業人員獲得適用于 NLP 的深度學習技術的簡要綜述,包括理論、算法、應用程序和最新技術成果,相關鏈接:https://github.com/omarsar/nlp_overview

NLP 概述。

微軟研究實驗室在數據科學的基礎上出版了免費的電子書,範圍從馬爾可夫鏈蒙特卡羅到隨機圖。電子書鏈接:https://www.datasciencecentral.com/profiles/blogs/new-book-foundations-of-data-science-from-microsoft-research-lab

《機器學習數學》是一本免費的電子書,介紹了機器學習中使用的最重要的數學概念。它還包括一些描述機器學習部分的 Jupyter 筆記本教程。電子書鏈接:https://mml-book.github.io/

Jean Gallier 和 Jocelyn Quaintance 撰寫了一本免費電子書,涵蓋了機器學習中使用的數學概念。電子書鏈接:https://www.cis.upenn.edu/~jean/math-deep.pdf

斯坦福大學發布了有關「自然語言理解」課程的

視頻播放列表

。

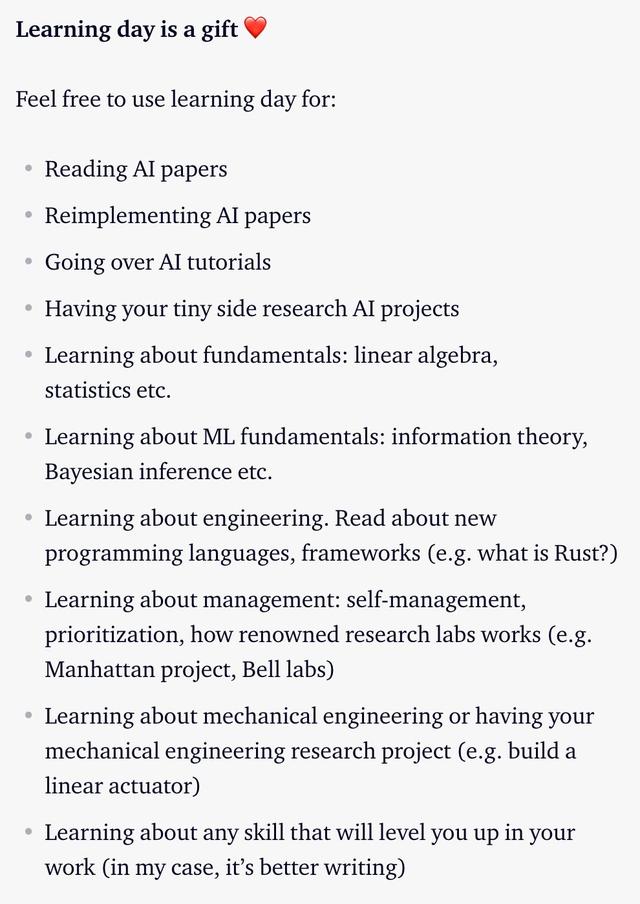

關于學習,OpenAI 整理了一份很棒的清單,提供了有關如何繼續學習和提高機器學習技能的建議。他們的員工每天都使用這些方法來不斷學習和擴展知識。清單鏈接:https://openai.com/blog/learning-day/

Adrian Rosebrock 發布了一本長達 81 頁的指南,介紹如何使用 Python 和 OpenCV 實現計算機視覺。指南鏈接:https://www.pyimagesearch.com/start-here/

Emily M. Bender 和 Alex Lascarides 出版了一本名爲《NLP 的語言基礎》的書。這本書的主要討論了 NLP 的意義,解釋了 NLP 在語義學和語用學方面的基礎。電子書鏈接:http://www.morganclaypoolpublishers.com/catalog_Orig/product_info.php?products_id=1451

Elad Hazan 在「機器學習的優化」上發表了他的課堂筆記,旨在通過簡明的數學和符號將機器學習訓練問題介紹爲一個優化問題。筆記鏈接:https://drive.google.com/file/d/1GIDnw7T-NT4Do3eC0B5kYJlzwOs6nzIO/view

Deeplearning.ai 還發表了一篇很棒的文章,討論了使用直觀、可互動的方式進行神經網絡參數優化。文章鏈接:https://www.deeplearning.ai/ai-notes/optimization/?utm_source=social&utm_medium=twitter&utm_campaign=BlogAINotesOptimizationAugust272019

Andreas Mueller 發布了一個視頻列表,對應一個名爲「應用機器學習」的新課程。視頻鏈接:https://www.youtube.com/playlist?list=PL_pVmAaAnxIQGzQS2oI3OWEPT-dpmwTfA

Fast.ai 發布了新 MOOC 課程,名爲「從基礎中進行深度學習」。課程連接:https://www.fast.ai/2019/06/28/course-p2v3/

麻省理工學院發布了有關「深度學習入門」課程的所有視頻和教學大綱。課程鏈接:https://www.youtube.com/playlist?list=PLtBw6njQRU-rwp5__7C0oIVt26ZgjG9NI

Chip Huyen 在推特上發布了一條極好的

入門機器學習的免費在線課程清單

。

Andrew Trask 出版的書名爲《Grokking-Deep-Learning》。這本書是理解神經網絡體系結構基本組成的一個好起點。電子書鏈接:https://github.com/iamtrask/Grokking-Deep-Learning

Sebastian Raschka 在 github 中上傳了 80 份筆記本,其中

介紹了如何實現不同的深度學習模型

,如 RNN 和 CNN。重要的是,所有模型都已在 PyTorch 和 TensorFlow 中實現。

教程(https://medium.com/@d3lm/understand-tensorflow-by-mimicking-its-api-from-scratch-faa55787170d)能夠幫你深入了解 TensorFlow 的工作原理。

Christian Perone 爲 PyTorch 設計了一個項目

。

Fast.ai 還發布了一個名爲「NLP 入門」的課程,並附帶一個播放列表。主題範圍從情感分析到主題建模再到 Transformer。視頻鏈接:https://www.youtube.com/playlist?list=PLtmWHNX-gukKocXQOkQjuVxglSDYWsSh9

Xavier Bresson 的演講可以幫助理解用于分子生成的圖卷積神經網絡。演講鏈接:https://ipam.wistia.com/medias/excbyr8gvv;PPT :http://helper.ipam.ucla.edu/publications/glws4/glws4_16076.pdf。

討論如何預訓練 GNN 的論文:https://arxiv.org/abs/1905.12265

在圖網絡的主題中,一些工程師使用圖網絡來預測分子和晶體的特性:https://www.eurekalert.org/pub_releases/2019-06/uoc–eug060719.php。

Google AI 團隊還發布了一篇出色的博客解釋了他們如何使用 GNN 進行氣味預測。博客鏈接:https://ai.googleblog.com/2019/10/learning-to-smell-using-deep-learning.html

如果你對使用 Graph Neural Networks 感興趣,這裏是各種 GNN 及其應用的全面概述:https://arxiv.org/pdf/1812.08434.pdf

這是約翰霍普金斯大學的 Rene Vidal 等無監督學習方法的視頻的播放列表:https://www.youtube.com/playlist?list=PLFInMJnvb3owAddRh4qk2gCX25kGLDay-

如果你有興趣將預訓練的 TensorFlow 模型轉換爲 PyTorch,可以看 Thomas Wolf 的這篇博客:https://medium.com/huggingface/from-tensorflow-to-pytorch-265f40ef2a28

想了解生成型深度學習嗎?David Foster 寫了一本很棒的書,教數據科學家如何應用 GAN 和編碼器-解碼器模型來完成繪畫、寫作和作曲。電子書鏈接:https://www.oreilly.com/library/view/generative-deep-learning/9781492041931/;這是本書隨附的官方代碼:https://github.com/davidADSP/GDL_code,其中包含 TensorFlow 代碼。利用(https://github.com/MLSlayer/Generative-Deep-Learning-Code-in-Pytorch)也可以將代碼轉換爲 PyTorch。

該 Colab 筆記本包含一些代碼塊,用于實踐和了解因果推理概念,例如幹預(intervention)、反事實等。鏈接:https://colab.research.google.com/drive/1rjjjA7teiZVHJCMTVD8KlZNu3EjS7Dmu#scrollTo=T9xtzFTJ1Uwf

這是 Sebastian Ruder,Matthew Peters,Swabha Swayamdipta 和 Thomas Wolf 提供的 NAACL 2019 的「自然語言處理中的轉移學習」教程的材料。材料鏈接:https://github.com/huggingface/naacl_transfer_learning_tutorial。他們還提供了配套的 Google Colab 筆記本:https://colab.research.google.com/drive/1iDHCYIrWswIKp-n-pOg69xLoZO09MEgf

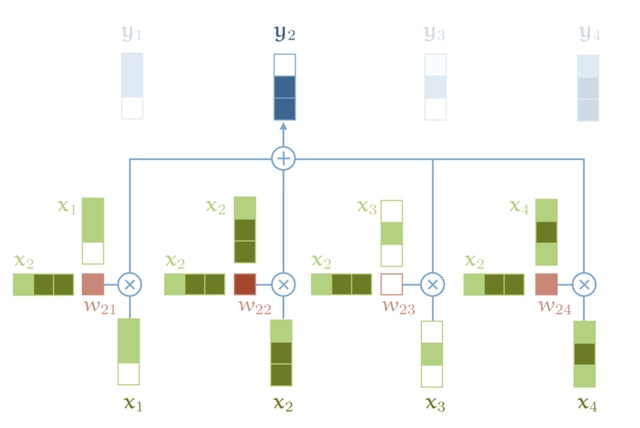

Jay Alammar 的另一篇很棒的博客關于

數據表示

的主題。他還寫了許多其他有趣的插圖指南,包括 GPT-2 和 BERT。Peter Bloem 還發表了非常詳細的博客,解釋了構成 Transformer 的所有要素。博客鏈接:http://peterbloem.nl/blog/transformers

標准自我注意力機制的可視化圖,圖片來源:http://peterbloem.nl/blog/transformers

這是 Mihail Eric 撰寫的關于 ACL 2019 NLP 趨勢的精彩概述。包括將知識注入 NLP 體系結構、可解釋性和減少偏見等。文章鏈接:https://www.mihaileric.com/posts/nlp-trends-acl-2019/。如果你感興趣,這裏還有另外幾個概述。鏈接 2:https://medium.com/@mgalkin/knowledge-graphs-in-natural-language-processing-acl-2019-7a14eb20fce8和鏈接 3:http:/ /noecasas.com/post/acl2019/ 。

斯坦福(CStan)發布了 CS231n 2019 版的完整課程大綱。課程鏈接:http://cs231n.stanford.edu/syllabus.html

David Abel 發布了 ICLR 2019 的概述。文章鏈接:https://david-abel.github.io/notes/iclr_2019.pdf。他也提供了

NeurlPS2019 的綜述

。

李沐的《

動手學深度學習

》是一本很棒的書,它向讀者介紹了有關深度學習的相關內容。

關于 BERT、ELMo等用于遷移學習 NLP 的插圖指南鏈接如下:http://jalammar.github.io/illustrated-bert/

圖片來源:http://jalammar.github.io/illustrated-bert/

Fast.ai 發布了 2019 年版「面向程序員的實用深度學習」課程。課程鏈接:https://www.fast.ai/2019/01/24/course-v3/

由 Pieter Abbeel 和其他教授設計的這門課程,可以幫助你了解關于深度無監督學習的知識。課程鏈接:https://sites.google.com/view/berkeley-cs294-158-sp19/home

Gilbert Strang 出版了一本

與線性代數和神經網絡有關的新書

。電子書鏈接:http://math.mit.edu/~gs/learningfromdata/

「Scipy 講義」是一系列課程,教你如何掌握 matplotlib,NumPy 和 SciPy 等工具。課程鏈接:https://scipy-lectures.org/

這裏還有一份關于理解高斯過程的優秀課程。課程鏈接:https://peterroelants.github.io/posts/gaussian-process-tutorial/

這是一篇必讀的文章,其中 Lilian Weng 深入探討了通用語言模型,例如 ULMFit、OpenAI GPT-2 和 BERT。文章鏈接:https://lilianweng.github.io/lil-log/2019/01/31/generalized-language-models.html

Papers with Code 是一個網站,顯示了精選的帶有代碼和最新成果的機器學習論文列表:https://paperswithcode.com/

Christoph Molnar 發布了第一版的《可解釋性機器學習》,該書涉及用于更好地解釋機器學習算法的重要技術。鏈接:https://christophm.github.io/interpretable-ml-book/

David Bamman 發布了完整的課程提綱以及加州大學伯克利分校自然語言處理課程的 PPT。課程鏈接:http://people.ischool.berkeley.edu/~dbamman/nlp18.html

伯克利發布了「應用 NLP」類的所有材料。鏈接:https://github.com/dbamman/anlp19

Aerin Kim 是 Microsoft 的高級研究工程師,她撰寫了與應用數學和深度學習有關的文章,主題包括條件獨立性、伽瑪分布等。文章鏈接:https://towardsdatascience.com/@aerinykim

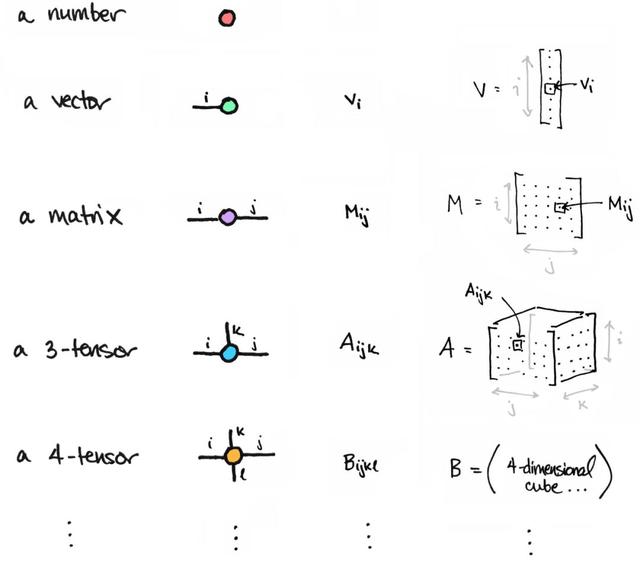

Tai-Danae Bradley 撰寫了博客,討論了

如何理解矩陣和張量

。本文以可視化效果編寫,有助于更好地理解在矩陣上執行的某些轉換和操作。

人工智能中的道德

倫理學可能是今年人工智能系統中討論最多的方面之一,其中包括圍繞偏見、公平和透明度等方面的討論。本節提供了有關該主題的有趣故事和論文清單:

「Does mitigating ML’s impact disparity require treatment disparity?」一文討論了通過對真實數據集進行實驗且應用不同學習過程的結果。文章鏈接:http://papers.nips.cc/paper/8035-does-mitigating-mls-impact-disparity-require-treatment-disparity

HuggingFace 發表了一篇文章在人工智能對話中開源 NLP 技術背景下的倫理問題。文章鏈接:https://medium.com/huggingface/ethical-analysis-of-the-open-sourcing-a-state-of-the-art-the-art-conversational-ai-852113c324b2

隨著我們繼續將 AI 的技術引入社會,探究倫理在 AI 研究中的作用是一項重要的工作。下面的論文提供了「倫理相關的研究在領先的人工智能、機器學習和機器人領域的應用」的分析。文章鏈接:https://arxiv.org/abs/1809.08328

在 NAACL 2019 上發表的論文討論了除偏方法如何掩蓋詞嵌入中的性別偏見。文章鏈接:https://arxiv.org/abs/1903.03862

可以聽聽 Zachary Lipton 在他的論文《Troubling Trends in ML Scholarship》中做的演講:https://www.youtube.com/watch?v=A2Jtqi_oa2Y]。附摘要:https://medium.com/dair-ai/an-overview-of-troubling-trends-in-machine-learning-scholarship-582df3caa518

Gary Marcus 和 Ernest Davis 發表了他們的書《重啓人工智能:構建我們可信賴的人工智能》。本書的主題是討論實現強大的人工智能必須采取的步驟。鏈接:https://www.amazon.com/Rebooting-AI-Building-Artificial-Intelligence/dp/1524748250

關于 AI 進步的話題,François Chollet 也寫了一篇令人印象深刻的論文,提出更好的方法來測量智力。文章鏈接:https://arxiv.org/abs/1911.01547

由 Andrew Trask 提出的有關差異化隱私、聯合學習和加密 AI 等主題的 Udacity 課程鏈接如下:https://www.udacity.com/course/secure-and-private-ai–ud185

關于隱私主題,Emma Bluemke 撰寫了一篇很棒的文章,討論了如何在保護患者隱私的同時訓練機器學習模型。文章鏈接:https://blog.openmined.org/federated-learning-differential-privacy-and-encrypted-computation-for-medical-imaging/

在今年年初,Mariya Yao 發布了一份關于 AI 倫理的綜合研究論文摘要。盡管論文參考清單來自 2018 年,但它們今天仍然適用。文章鏈接:https://www.topbots.com/most-important-ai-ethics-research/

原文鏈接:https://medium.com/dair-ai/nlp-year-in-review-2019-fb8d523bcb19原文 PDF:https://github.com/omarsar/nlp_highlights