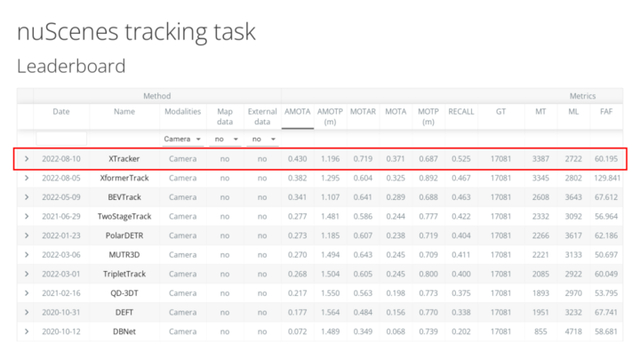

近日,廣汽研究院X lab團隊在國際權威的nuScenes自動駕駛測試競賽中,依靠自主研發的XTracker方法在動態多目標跟蹤MOT(Multi-Object Tracking)領域獲得純視覺榜單全球第一名,並將關鍵指標AMOTA(多目標跟蹤平均准確度)從此前39.8%大幅提升到43.0%。

nuScenes數據集是國際公認的權威自動駕駛公開數據集之一,數據采集自美國波士頓和新加坡的實際自動駕駛場景,是第一個提供360度的全傳感器覆蓋,同時包括攝像頭、激光雷達和毫米波雷達數據的數據集,是唯一提供雷達數據標注的數據集,覆蓋多種氣候條件及多種道路場景,數據集總共包含了1000個場景、140萬幀圖像、39萬幀激光雷達點雲、23個物體類別、140萬個三維標注框。

動態多目標跟蹤MOT是對感知數據中檢測出的多個動態目標重建運動軌迹,以確保隨著時間推移動態目標軌迹ID不變,是自動駕駛中目標意圖與軌迹預測、決策規劃等下遊任務的重要依賴項,在自動駕駛行車中跟車、變道等場景中起到關鍵作用。

近年來,隨著自動駕駛的火熱,數據、算法、算力成爲企業之間的競爭要塞,一方面參與純視覺3D目標跟蹤的團隊技術實力均處于世界先進水平,競爭十分激烈,不僅涵蓋了理想汽車、地平線、DeepMotion、Aurora等業界知名企業,還吸引了麻省理工學院、卡內基·梅隆大學、清華大學、複旦大學、華中科技大學等國內外重點高校;另一方面,純視覺多目標跟蹤需要處理不同光線、視線遮擋、圖像模糊等關鍵問題。目前業內尚未有成熟的技術可參照,識別跟蹤速度慢、目標運動模糊、准確率低等問題成爲行業共同難點。

廣汽研究院X lab團隊提出了XTracker方法,整體上有三大技術突破:

一是在自動駕駛行業內首次將跟蹤的多視角數據,通過Transformer統一轉換到BEV(Bird’s Eye View, 鳥瞰圖)特征空間下,從Decoder輸出聚合後的BEV表征。

二是首個在BEV空間下的端到端跟蹤方法——XTracker,解決了傳統的跟蹤方案主要采用運動建模或相似性建模,導致檢測和跟蹤之間存在信息流斷點,XTracker采用端到端的統一建模方式,使檢測和跟蹤能夠一起訓練,結構簡單、高效。

三是結合自車運動和多幀連續變化的方法,更好地完成時序特征的對齊,提高BEV表征空間下運動預測的魯棒性*。

目前自動駕駛主要分爲兩條探索路徑,一條是以攝像頭爲主的視覺感知路線,另一條是以激光雷達爲主的多傳感器融合路線。在自動駕駛視覺感知技術大規模應用過程中,尤其是在汽車對周圍運動物體的感知跟蹤領域,動態多目標跟蹤MOT是技術要求極高的基礎性感知技術任務,該技術作爲自動駕駛感知部分的必備環節,將直接影響到自動駕駛系統魯棒性和用戶體驗感。廣汽研究院X lab團隊深耕自動駕駛視覺領域,推進多目標跟蹤技術在自動駕駛落地場景中的應用,助力廣汽智能化升級。

作者:王鳴幽

來源:第一電動網(www.d1ev.com)